Mit Sprache, Mimik und Gestik zeigen Menschen, ob sie eine Erklärung verstanden haben. Diese multimodale Kommunikation soll auch in Erklärdialogen mit KI-Systemen eingesetzt werden. Forscher*innen des TRR 318 stellten auf der ICMI 2024, der 26. internationalen Konferenz zu multimodaler Interaktion, ihre Ansätze und Ergebnisse in dem Bereich vor. Dafür reisten vier Mitglieder des Transregios vom 4. bis 8. November nach San José, Costa Rica.

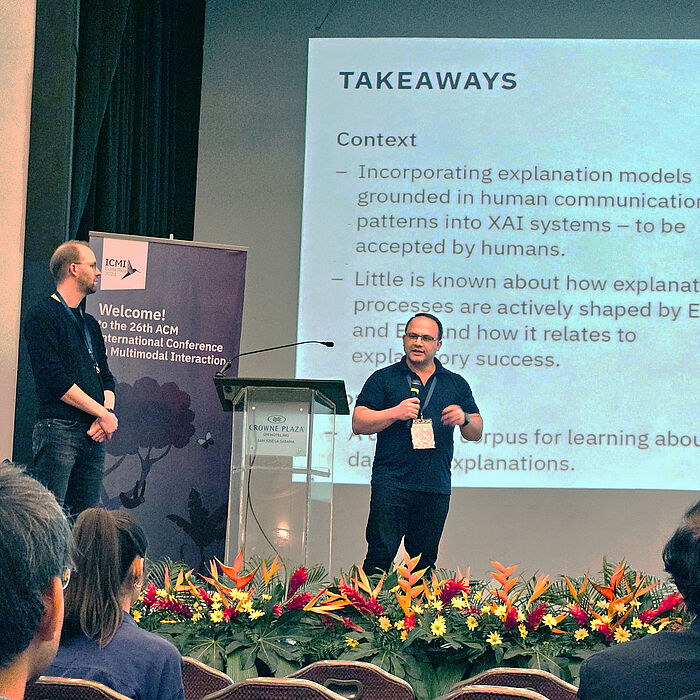

Der TRR 318 war am ersten Konferenztag mit einem Workshop zu einem zentralen Forschungsthema im Transregio beteiligt: Die Projektleiter Prof. Dr.-Ing. Hendrik Buschmeier und Prof. Dr.-Ing. Stefan Kopp organisierten mit Prof. Dr. Teena Hassan von der Hochschule Bonn-Rhein-Sieg einen Workshop zu multimodaler Ko-Konstruktion von Erklärungen mit XAI.

XAI, also Erklärbare Künstliche Intelligenz, zielt darauf ab, KI-Systeme transparent und verständlich zu machen. „Allerdings richten sich die derzeitigen Methoden hauptsächlich an Expert*innen“, sagt Buschmeier. „Währenddessen konzentriert sich die multimodale Interaktionsforschung darauf, sinnvolle Kommunikation zwischen Menschen und KI-Systemen zur ermöglichen. Der Workshop hat dementsprechend eine Brücke geschlagen zwischen XAI und multimodaler Interaktion.“

Die knapp 30 Teilnehmenden des Workshops untersuchten interaktive und soziale Prozesse in Erklärsituationen, wobei der Schwerpunkt auf gesprochener Sprache, Blick und Gestik lag. „Unser Ziel war es, XAI-Erklärungen als multimodale, interaktive Herausforderung zu sehen. Durch die Vernetzung zwischen den Forscher*innen in den Bereichen XAI und Multimodale Interaktion fördern wir die Arbeit an verständlichen XAI-Systemen“, so Buschmeier.

Im Workshop präsentierte unter anderem Amit Singh, Psycholinguist und Doktorand bei der TRR-Sprecherin Prof. Dr. Katharina Rohlfing, seine Forschung zum Blickverhalten während des erklärenden Dialogs zwischen Mensch und Roboter. „Eine Online-Methode, wie ein Eye-Tracker, ermöglicht es, die kognitiven Grundlagen der Aufmerksamkeit während eines Erklärdialogs zu untersuchen,“ sagt Singh. „Unsere Analyse zeigt, wie sich die Aufmerksamkeit auf Partner*in und Aufgabe im Laufe der Zeit während des Erklärdialogs verändert – ein zentraler Untersuchungsschwerpunkt im Projekt A05.“

Darüber hinaus stellten die Wissenschaftler*innen zwei weiterer Projekte des Transregios ihre Forschung auf der Konferenz vor. Dr. Olcay Türk, Linguist im Projekt A02 „Verstehensprozess einer Erklärung beobachten und auswerten” analysierte mit seinen Kolleg*innen die Vorhersagbarkeit des Verständnisses in Erklärsituationen auf der Grundlage multimodaler Hinweise. Das Team untersuchte, wie Verstehen von Nicht-Verstehen von einem Klassifikator identifiziert werden kann. „Die Ergebnisse unserer Studie zeigen auf, wie relevant multimodale Darstellungen in Erklärungen sind“, so Türk.

Aus dem Projekt INF „Kriterien für die Bewertung von Erklärungsqualität“ stellte Meisam Booshehri ein konzeptionelles Modell der wichtigsten Faktoren vor, die zum Erfolg von dialogischen Erklärungen beitragen. Zusammen mit Prof. Dr. Hendrik Buschmeier und Prof. Dr. Philipp Cimiano charakterisierte er Erklärdialoge, in denen Gesprächspartner abwechselnd den Erklärungsprozess vorantreiben. Dafür annotierte der Informatiker und Doktorand einige hundert dialogische Erklärungen. „Wir haben den Zusammenhang zwischen dem Erklärungsprozess und dem Erfolg einer Erklärung berechnet und Faktoren identifiziert, die zum Erfolg einer Erklärung beitragen“, sagt Booshehri.

Die ICMI (ACM International Conference on Multimodal Interaction / Internationale Konferenz zu multimodaler Interaktion) ist eine wissenschaftliche Konferenz, die sich auf multimodale Interaktion und Kommunikation konzentriert. Sie bringt Forscher*innen aus verschiedenen Disziplinen wie Informatik, Kognitionswissenschaften und Linguistik zusammen. Ihr Ziel ist es, menschliche Interaktionen mit Maschinen natürlicher und effektiver zu gestalten.

Workshop Multimodal Co-Construction of Explanations with XAI

Forschungsartikel mit Beteiligung des TRR 318:

-

Booshehri, M., Buschmeier, H., & Cimiano, P. (2024). A model of factors contributing to the success of dialogical explanations. Proceedings of the 26th ACM International Conference on Multimodal Interaction, 373–381. https://doi.org/10.1145/3678957.3685744

-

Türk, O., Lazarov, S., Wang, Y., Buschmeier, H., Grimminger, A., & Wagner, P. (2024). Predictability of understanding in explanatory interactions based on multimodal cues. Proceedings of the 26th ACM International Conference on Multimodal Interaction, 449–458. https://doi.org/10.1145/3678957.3685741

-

Singh, A., & Rohlfing K. J. (2024). Coupling of task and partner model: Investigating the intra-individual variability in gaze during human-robot explanatory dialogue. ICMI Companion '24: Companion Proceedings of the 26th International Conference on Multimodal Interaction, 218–224. https://doi.org/10.1145/3686215.3689202

Überblicksartikel zum Workshop

-

Buschmeier, H., Kopp, S., & Hassan, T. (2024). Multimodal Co-Construction of Explanations with XAI Workshop. Proceedings of the 26th ACM International Conference on Multimodal Interaction, 698–699. https://doi.org/10.1145/3678957.3689205