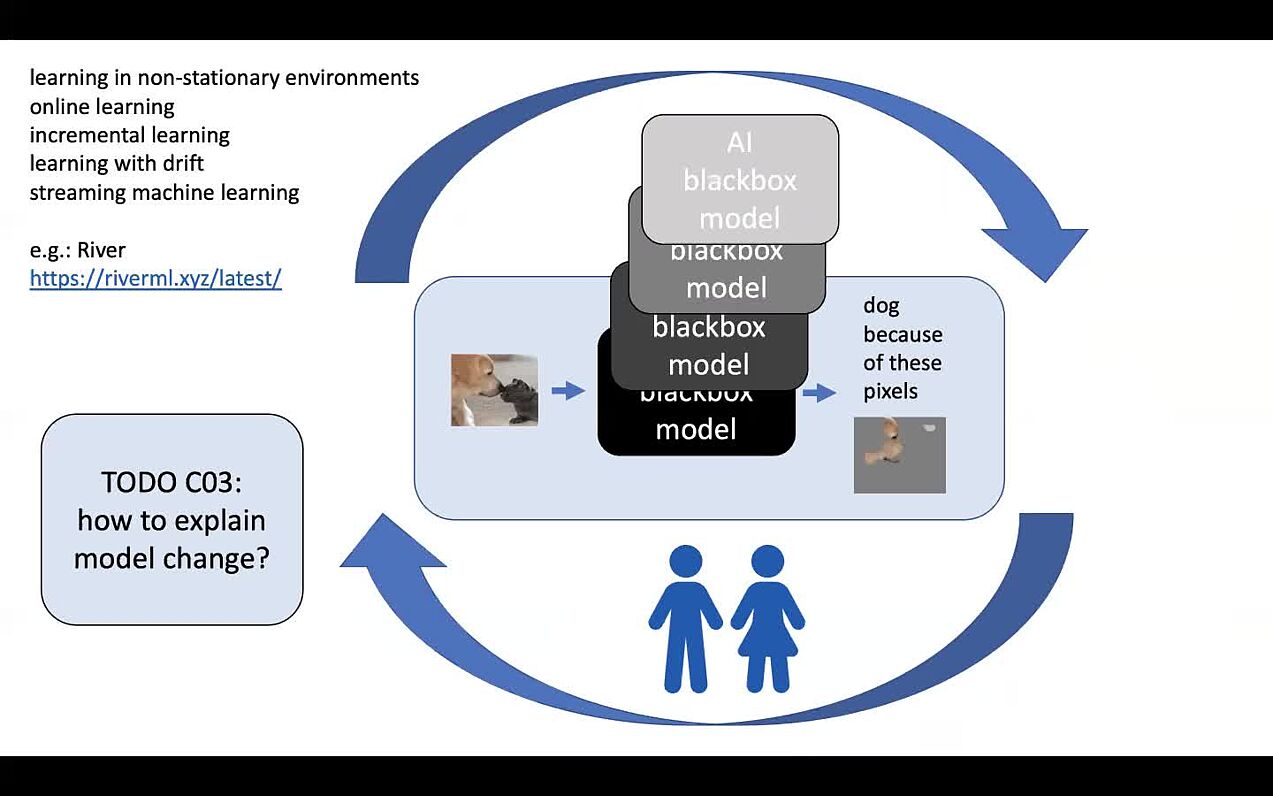

Projekt C03: Interpretierbares maschinelles Lernen: Veränderung erklären

Maschinelle Lernverfahren werden heutzutage oft in dynamischen Umgebungen wie sozialen Netzwerken, Logistik und Verkehr, Handel und Finanzen oder im Gesundheitswesen verwendet, in denen kontinuierlich neue Daten erzeugt werden. Um auf mögliche Veränderungen der zugrunde liegenden Prozesse zu reagieren, und sicherzustellen, dass die gelernten Modelle weiterhin zuverlässig funktionieren, müssen diese fortlaufend adaptiert werden. Diese Veränderungen sollten, wie das Modell selbst, durch Erklärungen für Nutzer*innen transparent gehalten werden. Dabei müssen die anwendungsspezifischen Bedürfnisse berücksichtigt werden. Wie und warum sich verschiedene Arten von Modellen verändern, betrachten die Wissenschaftler*innen des Projekts C03 aus einer theoretisch-mathematischen Perspektive. Ihr Ziel ist es, Algorithmen zu entwickeln, die Modellveränderungen effizient und zuverlässig erkennen und intuitiv erklären.

Forschungsgebiete: Informatik

Publikationen

Exact Computation of Any-Order Shapley Interactions for Graph Neural Networks

M. Muschalik, F. Fumagalli, P. Frazzetto, J. Strotherm, L. Hermes, A. Sperduti, E. Hüllermeier, B. Hammer, in: The Thirteenth International Conference on Learning Representations (ICLR), 2025.

Explaining Outliers using Isolation Forest and Shapley Interactions

R. Visser, F. Fumagalli, E. Hüllermeier, B. Hammer, in: Proceedings of the European Symposium on Artificial Neural Networks (ESANN), 2025.

Unifying Feature-Based Explanations with Functional ANOVA and Cooperative Game Theory

F. Fumagalli, M. Muschalik, E. Hüllermeier, B. Hammer, J. Herbinger, in: Proceedings of The 28th International Conference on Artificial Intelligence and Statistics (AISTATS), PMLR, 2025, pp. 5140–5148.

Adaptive Prompting: Ad-hoc Prompt Composition for Social Bias Detection

M. Spliethöver, T. Knebler, F. Fumagalli, M. Muschalik, B. Hammer, E. Hüllermeier, H. Wachsmuth, in: L. Chiruzzo, A. Ritter, L. Wang (Eds.), Proceedings of the 2025 Conference of the Nations of the Americas Chapter of the Association for Computational Linguistics: Human Language Technologies (Volume 1: Long Papers), Association for Computational Linguistics, Albuquerque, New Mexico, 2025, pp. 2421–2449.

No learning rates needed: Introducing SALSA - Stable Armijo Line Search Adaptation

P. Kenneweg, T. Kenneweg, F. Fumagalli, B. Hammer, in: 2024 International Joint Conference on Neural Networks (IJCNN), 2024, pp. 1–8.

Beyond TreeSHAP: Efficient Computation of Any-Order Shapley Interactions for Tree Ensembles

M. Muschalik, F. Fumagalli, B. Hammer, E. Huellermeier, in: Proceedings of the AAAI Conference on Artificial Intelligence (AAAI), 2024, pp. 14388–14396.

SVARM-IQ: Efficient Approximation of Any-order Shapley Interactions through Stratification

P. Kolpaczki, M. Muschalik, F. Fumagalli, B. Hammer, E. Huellermeier, in: Proceedings of The 27th International Conference on Artificial Intelligence and Statistics (AISTATS), PMLR, 2024, pp. 3520–3528.

KernelSHAP-IQ: Weighted Least Square Optimization for Shapley Interactions

F. Fumagalli, M. Muschalik, P. Kolpaczki, E. Hüllermeier, B. Hammer, in: Proceedings of the 41st International Conference on Machine Learning (ICML), PMLR, 2024, pp. 14308–14342.

shapiq: Shapley interactions for machine learning

M. Muschalik, H. Baniecki, F. Fumagalli, P. Kolpaczki, B. Hammer, E. Huellermeier, in: Advances in Neural Information Processing Systems (NeurIPS), 2024, pp. 130324–130357.

Approximating the shapley value without marginal contributions

P. Kolpaczki, V. Bengs, M. Muschalik, E. Hüllermeier, in: Proceedings of the AAAI Conference on Artificial Intelligence (AAAI), 2024, pp. 13246–13255.

Incremental permutation feature importance (iPFI): towards online explanations on data streams

F. Fumagalli, M. Muschalik, E. Hüllermeier, B. Hammer, Machine Learning 112 (2023) 4863–4903.

iPDP: On Partial Dependence Plots in Dynamic Modeling Scenarios

M. Muschalik, F. Fumagalli, R. Jagtani, B. Hammer, E. Huellermeier, in: Proceedings of the World Conference on Explainable Artificial Intelligence (XAI), 2023.

iSAGE: An Incremental Version of SAGE for Online Explanation on Data Streams

M. Muschalik, F. Fumagalli, B. Hammer, E. Huellermeier, in: Machine Learning and Knowledge Discovery in Databases: Research Track - European Conference (ECML PKDD), Springer Nature Switzerland, 2023.

On Feature Removal for Explainability in Dynamic Environments

F. Fumagalli, M. Muschalik, E. Hüllermeier, B. Hammer, in: Proceedings of the European Symposium on Artificial Neural Networks (ESANN), 2023.

SHAP-IQ: Unified Approximation of any-order Shapley Interactions

F. Fumagalli, M. Muschalik, P. Kolpaczki, E. Hüllermeier, B. Hammer, in: Advances in Neural Information Processing Systems (NeurIPS), 2023, pp. 11515--11551.

Agnostic Explanation of Model Change based on Feature Importance

M. Muschalik, F. Fumagalli, B. Hammer, E. Huellermeier, KI - Künstliche Intelligenz 36 (2022) 211–224.

Alle Publikationen anzeigen