Projekt B03: Nutzer*innen und Erklärbedürfnisse in real-weltlichen Kontexten

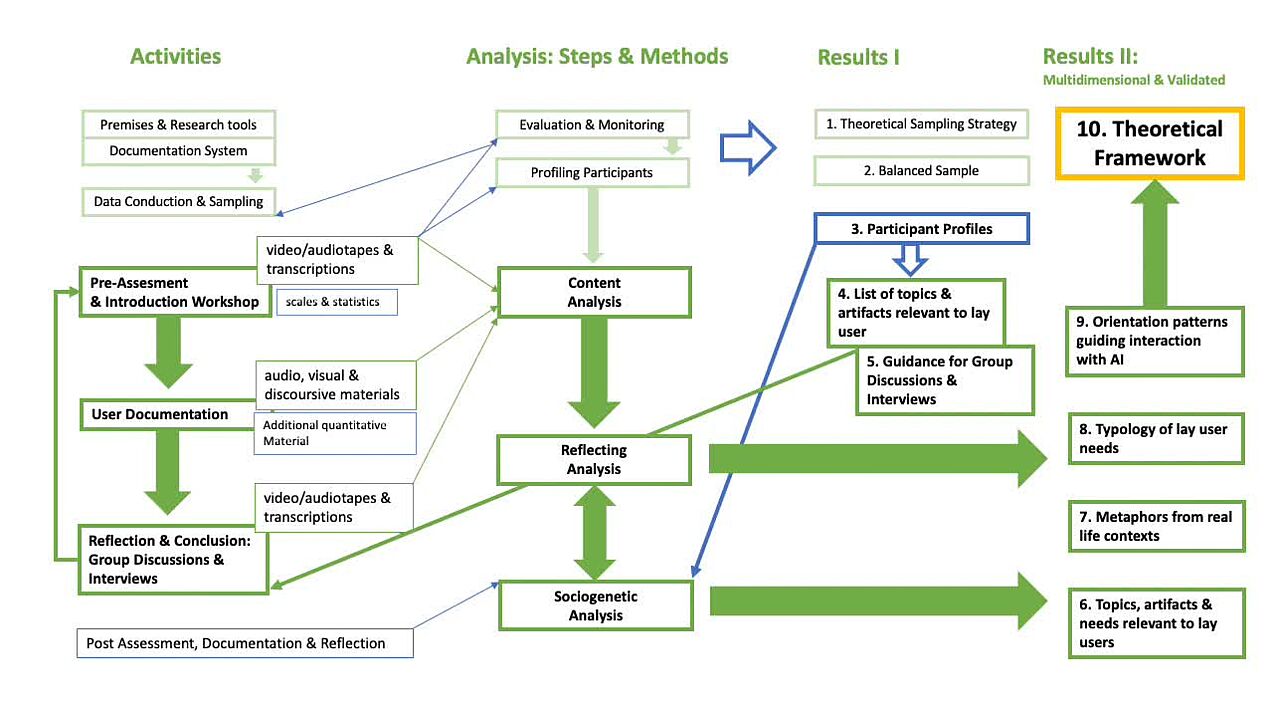

Das Projekt B03 untersuchte in der ersten Förderphase, wie Lai*innen künstliche Intelligenz (KI) in ihrem Alltag verstehen. Auf der Grundlage qualitativer Daten von 63 Teilnehmer*innen aus Deutschland und Großbritannien analysierte das Projekt alltägliche Erfahrungen mit KI-Technologien anhand von Umfragen, digitalen Tagebüchern, Interviews und Gruppendiskussionen.

Die Forschung zeigt, wie der individuelle Kontext und Vorwissen beeinflussen, wann und warum Menschen Erklärungen zu KI für notwendig halten. Dabei stützen sich Nutzer*innen häufig auf nicht-technisches Wissen, um KI zu interpretieren, und politische sowie soziale Überlegungen spielen oft eine größere Rolle als technische Aspekte.

Das Projekt kommt zu dem Schluss, dass die Forschung im Bereich der erklärbaren KI (XAI) über rein technische Lösungen hinausgehen muss, um die sozialen Prozesse besser zu verstehen, durch die Menschen KI-Systeme interpretieren und bewerten.

Forschungsgebiete: Soziologie, Medienwissenschaften

Projektlaufzeit: 07/2021-12/2025

Ehemalige Mitglieder

Prof. Dr. Ilona Horwath, Projektleitung

Dr. Christian Schulz, Wissenschaftlicher Mitarbeiter

Dr. Patricia Jimenez Lugo, Wissenschaftliche Mitarbeiterin

Lea Biere, Assoziiertes Mitglied

Josefine Finke, Wissenschaftliche Mitarbeiterin

Patrick Henschen, Wissenschaftlicher Mitarbeiter

Publikationen

Structures Underlying Explanations

P. Jimenez, A.L. Vollmer, H. Wachsmuth, in: K. Rohlfing, K. Främling, B. Lim, S. Alpsancar, K. Thommes (Eds.), Social Explainable AI: Communications of NII Shonan Meetings, Springer Singapore, n.d.

Investigating Co-Constructive Behavior of Large Language Models in Explanation Dialogues

L. Fichtel, M. Spliethöver, E. Hüllermeier, P. Jimenez, N. Klowait, S. Kopp, A.-C. Ngonga Ngomo, A. Robrecht, I. Scharlau, L. Terfloth, A.-L. Vollmer, H. Wachsmuth, ArXiv:2504.18483 (2025).

Investigating Co-Constructive Behavior of Large Language Models in Explanation Dialogues

L. Fichtel, M. Spliethöver, E. Hüllermeier, P. Jimenez, N. Klowait, S. Kopp, A.-C. Ngonga Ngomo, A. Robrecht, I. Scharlau, L. Terfloth, A.-L. Vollmer, H. Wachsmuth, in: Proceedings of the 26th Annual Meeting of the Special Interest Group on Discourse and Dialogue, Association for Computational Linguistics, Avignon, France, n.d.

Forms of Understanding for XAI-Explanations

H. Buschmeier, H.M. Buhl, F. Kern, A. Grimminger, H. Beierling, J.B. Fisher, A. Groß, I. Horwath, N. Klowait, S.T. Lazarov, M. Lenke, V. Lohmer, K. Rohlfing, I. Scharlau, A. Singh, L. Terfloth, A.-L. Vollmer, Y. Wang, A. Wilmes, B. Wrede, Cognitive Systems Research 94 (2025).

Vernacular Metaphors of AI

C. Schulz, A. Wilmes , in: ICA Preconference Workshop “History of Digital Metaphors”, University of Toronto, May 25 , n.d.

(De)Coding social practice in the field of XAI: Towards a co-constructive framework of explanations and understanding between lay users and algorithmic systems

J. Finke, I. Horwath, T. Matzner, C. Schulz, in: Artificial Intelligence in HCI, Springer International Publishing , Cham, 2022, pp. 149–160.

(De)Coding Social Practice in the Field of XAI: Towards a Co-constructive Framework of Explanations and Understanding Between Lay Users and Algorithmic Systems

J. Finke, I. Horwath, T. Matzner, C. Schulz, in: Artificial Intelligence in HCI, Springer International Publishing, Cham, 2022, pp. 149–160.

Alle Publikationen anzeigen