Vor etwa einem Jahr bat Soziologe Nils Klowait ChatGPT, ein mausgesteuertes Spiel zu programmieren, in dem eine Katze Hotdogs ausweichen muss, die vom Himmel fallen. Damals sollte das Spiel veranschaulichen, wie ChatGPT es Menschen ohne Programmier-Erfahrung ermöglichen könnte, eine breitere Palette von technischen Aufgaben zu bewältigen und die tiefergehenden soziologischen Implikationen solcher Systeme zur Diskussion stellen. Das damals entstandene Spiel ließ sich, wie Nils Klowait feststellte, auch für seine weitergehende Forschung nutzen. Er und seine Kolleg*innen konnten nun erste Ergebnisse dieser Forschung im UCLA Co-Operative Action Lab vorstellen, eine Reihe von Veröffentlichungen in wissenschaftlichen Zeitschriften folgen in Kürze.

Wie konntest Du dieses einfache Computerspiel in Deine breitere Forschung integrieren?

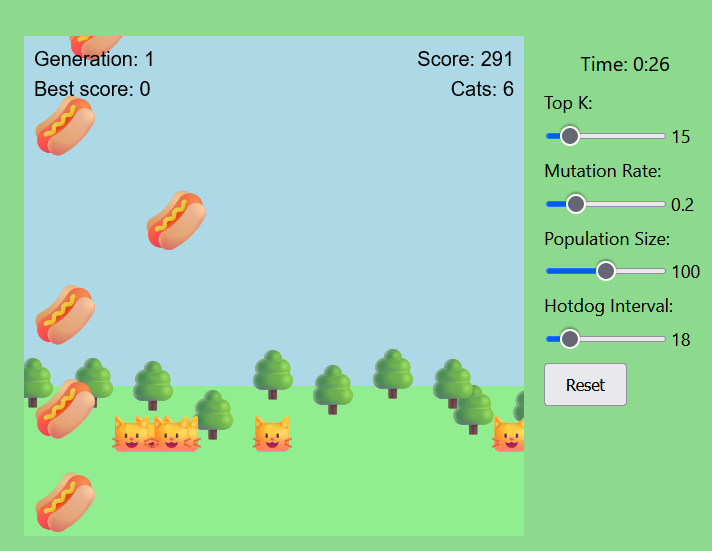

NK: Seit seiner ersten öffentlichen Version habe ich mit ChatGPT herumexperimentiert - bei neuen Technologien ist nie ganz klar, wo sie eingesetzt werden können und sollen. Mit der Zeit begann ich, die Möglichkeit zu untersuchen, ChatGPT für meine Forschung über Ko-Konstruktion zu nutzen. Mich interessiert die Frage, wie KI-Systeme so umgestaltet werden können, dass sie für eine Vielzahl von Nutzer*innen verständlicher sind und auch auf vielfältige Bedürfnisse eingehen. So entstand das Pilotprojekt „KI erklärt KI“: Können wir eine künstliche Intelligenz nutzen, um eine andere KI zu erklären? Ich habe das ursprüngliche Katzen-Hotdog-Spiel so modifiziert, dass es autonom läuft – jetzt gibt es viele Katzen, die vielen Hotdogs ausweichen müssen, wobei jede Katze von einem neuronalen Netz gesteuert wird.

Das System basiert auf dem Prinzip des bestärkenden Lernens (reinforcement learning), bei dem jede neue Katzengeneration bessere Strategien entwickelt, um die Hotdogs zu meiden und so lange wie möglich zu überleben. Der Evolutionsprozess kann von den Benutzer*innen mit Hilfe von Schiebereglern auf der rechten Seite angepasst werden. Bei bestimmten Einstellungen können sich die Katzen schneller anpassen, während falsche Einstellungen das Spiel komplett zum Absturz bringen. Die Idee war, eine spielerische Umgebung für Interaktionen mit KI zu schaffen, die für neue Benutzer*innen nicht sofort verständlich ist: Während es vielleicht klar ist, was der Schieberegler „Populationsgröße“ bewirkt, bleibt im Unklaren was mit „Hotdog-Intervall“ und „Top K“ gemeint ist. Was bedeutet „Score“? Außerdem hatten einige Schieberegler eine sofort sichtbare Wirkung – wenn man beispielsweise den Schieberegler „Hotdog-Intervall“ herunterdreht, erhöht sich die Anzahl der Hotdogs auf dem Bildschirm merklich.

Ziel war es, einen Moment situativer Unbestimmtheit zu erzeugen - der typisch ist für viele aktuelle Begegnungen mit KI - und gleichzeitig den Leuten genügend Werkzeuge an die Hand zu geben, um herauszufinden, was vor sich geht. Der Clou ist eine letzte Ergänzung - ChatGPT selbst.

Ganz rechts fügte ich ein Chat-Fenster mit GPT-4 – der zu dem Zeitpunkt leistungsfähigsten Konversations-KI –, um den Nutzer*innen bei spielbezogenen Fragen zu helfen. Der Chatbot - ich nannte ihn "Pythia" - wird mit detaillierten Informationen über das Spiel versorgt und hat Zugriff auf den gesamten Quellcode des Spiels. Damit simuliert das Spiel eine Situation, die zentrale Elemente des Forschungsparadigmas „Explainability“ abbildet und erlaubt, verwandte theoretische Annahmen zur Erklärbarkeit von KI auch empirisch zu analysieren.

Was haben die Teilnehmer*innen in dieser verwirrenden Situation getan, um sich zurechtzufinden?

NK: Ich hatte zuvor einige Erwartungen und fragte mich beispielsweise, ob die Nutzer*innen einfach Pythia um Hilfe bitten oder mit den Schiebereglern herumspielen würden. So wurde unser Pilotprojekt geboren. Mit Hilfe von Ilona Horwath, Hendrik Buschmeier, Maria Erofeeva und Michael Lenke stellten wir ein 20-minütiges Online-Experiment auf die Beine, bei dem Teilnehmer*innenpaare vor dieses System gesetzt wurden und eine von vier Aufgaben erfüllen mussten, die jedem Paar zufällig zugewiesen wurden:

1. Interagieren Sie 20 Minuten lang mit dem System.

2. Erreichen Sie innerhalb von 20 Minuten eine hohe Punktzahl.

3. Interagieren Sie 20 Minuten lang mit dem System. Erklären Sie evolutionäre Algorithmen anhand dieses Beispiels.

4. Machen Sie sich innerhalb von 20 Minuten mit dem System vertraut. Erklären Sie Pythia, wie es funktioniert – es wird Ihr Verständnis bewerten.

Die Teilnehmer*innen wurden paarweise dazu angehalten, laut miteinander zu sprechen - wir zeichneten auf, was sie sagten und taten, und auch ihre Interaktionen mit der Bildschirmoberfläche.

Hat das funktioniert? Haben sich die Teilnehmenden aktiv mit der erklärenden KI auseinandergesetzt?

NK: Wir haben eine Reihe überraschender erster Ergebnisse. Im Allgemeinen gibt es einen großen Unterschied zwischen den Vorstellungen der Entwickler*innen des Systems, also unseren eigenen Vorstellungen, und der tatsächlichen Interaktion. Zum Beispiel dachten einige der Teilnehmenden zunächst, das Ziel des Spiels sei es, so viele Katzen wie möglich mit Hotdogs zu treffen. Andere Teilnehmer*innen schworen darauf, dass sie die Katzen durch das Drücken von Tastaturtasten steuern konnten. Wieder andere spekulierten, dass Pythia eigentlich auf der Seite der Katzen steht und ein Gegner der menschlichen Teilnehmer*innen ist. Dies unterstreicht drei entscheidende Aspekte: Erkundung, Vertrauen und Zeit.

Was bedeutet der Aspekt der Erkundung genau?

NK: Die Teilnehmenden halten sich nicht unbedingt an die Pläne der System-Entwickler*innen: Wenn sie ein solches System ausprobieren, können sie zu unerwarteten Schlussfolgerungen darüber kommen, wie es funktioniert. Sie denken vielleicht, dass die Schieberegler nichts bewirken, oder dass das Spiel heimlich von einem Menschen in einem anderen Raum gesteuert wird. Das Gleiche gilt für die Erklärer-KI – obwohl Pythia sich selbst als Erklärer-KI vorstellte und als Erklärer-KI konsequent beim Thema blieb, glaubten nicht alle Teilnehmer*innen den Antworten. Immerhin könnte man daraus schließen, dass diese KIs zusammenarbeiten. Kurz gesagt, unsere Teilnehmenden versuchten, Instrumente zu entwickeln, um herauszufinden, was das System tut, aber sie nutzten nicht unbedingt die Werkzeuge, die wir erwartet hatten, oder sie nutzten sie auf ungewollte Weise. Sie waren ein wenig wie die frühen Wissenschaftler*innen, die versuchten, experimentelle Werkzeuge und Verfahren zu entwickeln.

Und welche Rolle spielt das Vertrauen bei diesen Begegnungen?

NK: Selbst wenn die Rolle des Erklärenden offensichtlich ist und selbst wenn das System genaue und relevante Erklärungen liefert, bedeutet das noch lange nicht, dass die Teilnehmenden diesen Erklärungen auch Glauben schenken und die Legitimität von Informationen nicht hinterfragen. Wie bei jedem anderen Hilfsmittel auch können Nutzer*innen ein System als zuverlässig einschätzen – oder eben auch als nicht verlässlich, insbesondere wegen der weitgehend bekannten, medial diskutierten Tendenz von ChatGPT, gelegentlich selbstbewusst vorgetragenen Unsinn zu erfinden. Ganz allgemein kann dieses Vertrauen durch die längerfristigen Beziehungen beeinflusst werden, die wir zu diesen Technologien aufbauen – ich habe zum Beispiel gelernt, dass mein Alexa-Lautsprecher nicht wirklich klug ist, aber ich kann mich darauf verlassen, dass er einen Timer stellt und mir auf Wunsch Instrumental-Jazz spielt. Ich würde ihn nie bitten, mir etwas zu erklären. Umgekehrt könnte man ChatGPT aufgrund seiner Eloquenz und seiner objektiv größeren Fähigkeiten mehr Vertrauen entgegenbringen. Grundsätzlich gibt es ein Rekursionsproblem: ChatGPT als erklärende Instanz für eine andere KI zu verwenden, könnte ein mächtiges Instrumentarium sein, um demokratischere Begegnungen zwischen Mensch und KI zu ermöglichen, aber ChatGPT muss vielleicht erst selbst transparenter und erklärbarer werden. Schließlich müssen die Teilnehmer*innen in der Lage sein, die Grenzen und Fähigkeiten von ChatGPT zu verstehen. Kurz gesagt, auf unserer Suche nach der Frage, ob eine KI eine andere KI erklären kann, müssen wir vielleicht erst einmal klären, ob und in welchen Dimensionen eine KI sich selbst erklären können muss.

Abschließend scheint die Zeit wesentlich für Pythias Rolle bei der Erkundung zu sein?

NK: In der Tat! Im Moment sind ChatGPT-ähnliche Systeme noch überwiegend Chat-ähnlich. Wir müssen eine Frage eintippen und oft eine ganze Weile auf eine Antwort warten. Ich biete Workshops an, in denen verschiedene Personen die Möglichkeit haben, sich kritisch mit künstlicher Intelligenz auseinanderzusetzen und Wege zu finden, ihre Entwicklung demokratischer zu gestalten. Als meine Kolleg*innen und ich den Teilnehmenden die Möglichkeit gaben, das Hotdog-Cat-System auszuprobieren, sprachen vor allem Personen, die in größeren Gruppen am Workshop teilnahmen, kaum mit Pythia. Ich denke, einer der Gründe dafür ist, dass die menschliche soziale Interaktion schnell abläuft: Wir tauschen Phrasen aus, fallen den anderen ins Wort, kommunizieren mit Gesten und unserem Körper, wir ändern schnell die Einstellungen von Schiebereglern.

Wenn man sich ein Video von einer beliebigen Interaktion zwischen mehreren Personen ansieht, wird deutlich, wie viel auf einmal passiert. Die Teilnehmer*Innen müssten diese schnelle Interaktion absichtlich unterbrechen und sorgfältig eine Frage an Pythia stellen, auf eine Antwort warten und dann möglicherweise eine Folgefrage stellen. Diese Art der Interaktion erfordert Konzentration und kann zu einem Hindernis für die Erkundung werden. Ich weiß nicht, wie sich dies im Laufe der Zeit ändern wird – es gibt jetzt sprachgesteuerte Versionen von ChatGPT. Vielleicht ist dies auch eine Frage der Anpassung. In unseren Daten ließen die Teilnehmer*innen Pythia manchmal Beiseite, um einfach nur zu beobachten, was auf dem Bildschirm passierte, während sie mit den anderen Teilnehmenden sprachen. In einigen Fällen stellten die Personen Pythia zunächst eine Reihe von Fragen und blätterten dann zu Pythias Antworten, wenn sie relevant wurden – hier wurde Pythia fast wie ein Handbuch genutzt, nicht wie ein gleichberechtigter Konversationsteilnehmender.

Ich denke, dass künftige Versionen solcher Erklär-Systeme die zeitliche Komponente ernst nehmen müssen – die derzeitige zeitliche Verzögerung von ChatGPTs Antworten ist nur dann problematisch, wenn sie bei der Gestaltung der Interaktion nicht berücksichtigt wird; schließlich schreiben wir uns regelmäßig Nachrichten und stören uns nicht daran, dass die Leute sich Zeit lassen, um zu antworten.

Hat der Austausch im Rahmen des Co-Operative Action Lab neue Impulse für Deine Forschung gegeben?

NK: Meine Kolleg*innen und ich nehmen schon seit Jahren am Co-Operative Action Lab teil, und dessen Einfluss auf unsere Arbeit kann gar nicht hoch genug eingeschätzt werden. Jede Woche analysieren wir gemeinsam Videoaufzeichnungen unterschiedlicher menschlicher Interaktionen, die von Forscher*innen vorgestellt werden, die das Material erhoben haben. Es ist eine Gelegenheit, Einblicke von sehr erfahrenen Wissenschaftler*innen auf diesem Gebiet zu erhalten. Aber noch entscheidender als der wissenschaftliche Austausch ist für mich die Atmosphäre: Die Teilnehmer*innen des Labors scheinen durch eine gegenseitige Fürsorge und eine Neugier für die Komplexität der sozialen Welt verbunden zu sein. Sei es bei der Analyse von Menschen, die sich umarmen, bei der Erklärung eines physikalischen Phänomens durch einen Lehrer für Schüler*Innen oder bei der Frage, wie ein rollstuhlfahrender Teilnehmender Eye-Tracking zur Steuerung eines Computers verwendet. Jedes Treffen strahlt diese Freundlichkeit und Liebe für die Vielfalt der sozialen Welt aus, es ist wirklich inspirierend. Die Leiterin des Labors, Professorin Marjorie H. Goodwin vom Fachbereich Anthropologie der UCLA, spielt eine Schlüsselrolle bei der Förderung dieser Atmosphäre, und ich bin unendlich dankbar, dass ich Teil des Labors sein kann.