Ein und dieselbe Erklärung kann entweder zu ausschweifend oder nicht ausführlich genug sein – je nachdem, wer die Person ist, der etwas erklärt wird. Wie Maschinen dieses Problem meistern und ihre Erklärstrategien individuell und in Echtzeit anpassen können, zeigen Informatiker*innen des TRR 318 in ihrem Modell „SNAPE“.

„Wenn eine Erklärung von einer Maschine korrekt und vollständig ist, heißt das noch nicht, dass sie auch verstanden wird. Der Erfolg einer Erklärung hängt auch von der Person ab, an die sich die Erklärung richtet“, sagt Amelie Robrecht, wissenschaftliche Mitarbeiterin im Teilprojekt A01 „Adaptives Erklären“ des Transregios. Gemeinsam mit Projektleiter Professor Dr. Stefan Kopp von der Arbeitsgruppe „Kognitive Systeme und soziale Interaktion“ an der Universität Bielefeld hat sie ein Modell für KI-Erklärstrategien in Echtzeit entwickelt. Das Modell betrachtet verschiedene sprachliche Ebenen einer Erklärung und verändert seine Strategie im Laufe der Interaktion.

„Unser Modell ist wichtig für die neueste Forschung zu erklärbarer künstlicher Intelligenz: KI-Systeme sollen mit personalisierten Erklärungen ausgestattet werden, die ihren Nutzer*innen aufzeigen, wie eine KI funktioniert und warum sie so handelt“, so Kopp. „Dies erfordert von der Maschine, dass sie selbstständig über den Inhalt der Erklärung entscheidet und eine Erklärstrategie wählt – zum Beispiel, ob gegebene Informationen vertieft oder neue Informationen eingeführt werden. Das schwierige daran ist, dass sich die Entscheidungsgrundlage dafür während einer Erklärung ständig ändert.“

Dynamisches Partnermodell als Grundlage für personalisierte Erklärung

Um die Erklärung an den Informationsbedarf des menschlichen Gegenübers anzupassen, nutzt die Maschine ein dynamisches Partnermodell: Das Partnermodell wird von der Maschine während des Dialogs konstruiert und gegebenenfalls verändert. Diesen Updateprozess in Echtzeit konnte die Doktorandin Amelie Robrecht anhand von simuliertem Feedbackverhalten demonstrieren. Sie wählte die fiktiven Personas Harry, Ron und Hermine. Am Anfang bekam die Maschine das Partnermodell von Hermine mitgeteilt. „Hermine ist interessiert, konzentriert und Expertin für alles. Das Feedback, das das Modell auf seine Erklärungen erhalten hat, passte allerdings nicht zu Hermine, sondern eher zu Harry, der sich schnell ablenken lässt und wenig Fachwissen mitbringt. Je mehr Feedback das Model bekommen hat, desto mehr hat es die Erklärstrategie verändert und sich an Harry ausgerichtet“, berichtet Robrecht.

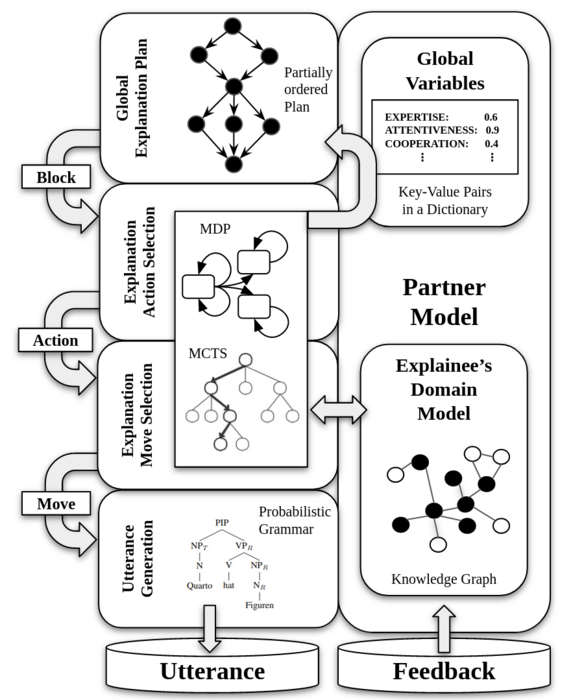

Das entwickelte Modell der Forschenden ist hierarchisch aufgebaut – auf der höchsten Ebene wird der nächste Themenbereich festgelegt, auf unterster Ebene der passende Satz gebildet. Jede der Ebenen interagiert mit dem aktuellen Partnermodell, um eine nutzerorientierte Erklärung zu garantieren. Als Antwortmöglichkeiten nutzt das Team aktuell: „+“ (verstanden), „-“ (nicht verstanden) und „None“ (keine Antwort). Wenn die Nutzer*innen das Erklärte verstehen, erhält das Modell Pluspunkte, wenn nicht Minuspunkte. Je nach Feedback der Nutzer*innen errechnet das Modell neue Wahrscheinlichkeiten für die beste Erklärung.

Forschungsartikel für internationale Konferenz zu Agenten und Künstlicher Intelligenz

Nach der Entwicklung und Modellierung des Modells planen die Informatiker*innen eine Studie mit realen Nutzer*innen. „Wir wollen herausfinden, ob die Nutzer*innen zufriedener mit einer automatischen Erklärung sind, wenn dahinter ein System steckt, das sich während der Interaktion anpasst“, sagt Robrecht.

Ihre Forschung haben Robrecht und Kopp festgehalten im Artikel „SNAPE: A Sequential Non-Stationary Decision Process Model for Adaptive Explanation Generation“ (deutsch: SNAPE: Ein sequentielles nicht-stationäres Entscheidungsprozessmodell für adaptive Erklärungsgenerierung). Vorgestellt wurde er auf der 15. internationalen Konferenz zu Agenten und Künstlicher Intelligenz ICAART. Forscher*innen, Ingenieur*innen und Praktiker*innen trafen sich vom 22.-24. Februar in Lissabon, Portugal, um Theorien und Anwendungen in diesem Bereich zu diskutieren.