Computerlinguisten des TRR 318 haben Dialoge mit fünf unterschiedlichen Erklärstufen untersucht. Ihre Ergebnisse stellen sie auf der internationalen Konferenz COLING vor.

„Die meisten Forschungsarbeiten über erklärbare Künstliche Intelligenz gehen davon aus, dass es eine ideale Erklärung gibt, mit der die Prozesse hinter KI verständlich werden. Alltägliche Erklärungen funktionieren aber ganz anders: Sie werden in einem Dialog zwischen der erklärenden Person und der Person, der die Erklärung gegeben wird, ko-konstruiert. Wir brauchen ein besseres Verständnis davon, wie Menschen in Dialogen erklären. Nur so kann KI lernen, mit Menschen zu interagieren“, sagt Prof. Dr. Henning Wachsmuth. Der Computerlinguist der Leibniz Universität Hannover (bis 30.9. Universität Paderborn) leitet die Teilprojekte C04 und INF im TRR 318.

Wachsmuth und sein Mitarbeiter Milad Alshomary haben in ihrer ersten Studie im INF-Projekt eine Sammlung von dialogischen Erklärungen mit computergestützten Methoden darauf untersucht, wie Menschen erklären, und wie KI diesen Prozess imitieren kann. „Dabei konnten wir empirische Erkenntnisse darüber gewinnen, wie Expert*innen Erklärungen an Gesprächspartner*innen unterschiedlicher Niveaus ausrichten“, sagt Milad Alshomary, Doktorand im TRR 318. „Außerdem haben wir mithilfe eines Sprachverarbeitungsprogramms erste systematische Vorhersagen zum Erklärungsablauf in Dialogen entwickelt.“

Englische Erklärdialoge als Grundlage der Studie

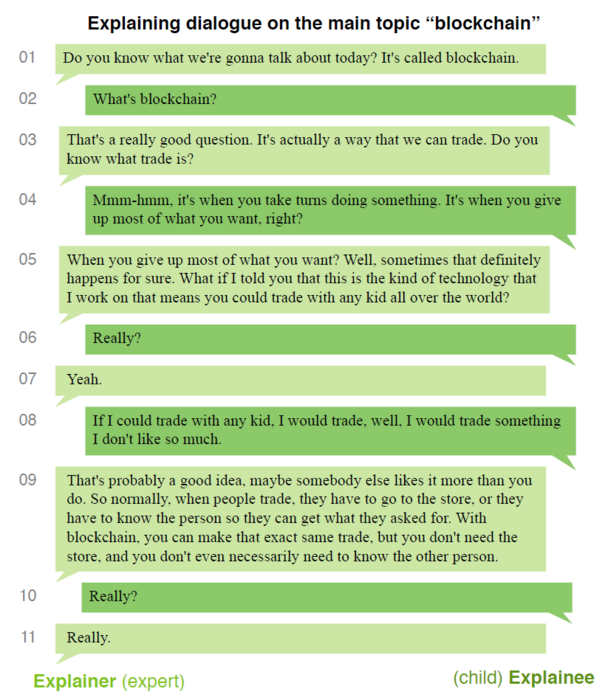

Wachsmuth und Alshomary haben in ihrer Studie 65 englische Dialoge aus der Wired-Videoserie „5 Levels“ analysiert. In der Serie erklären Expert*innen wissenschaftsbezogene Themen in fünf unterschiedlichen Schwierigkeitsstufen: Zuerst beschreiben sie den Begriff – beispielsweise „Blockchain“ – einem Kind, dann einem Teenager, danach jeweils einer Person, die studiert und promoviert, und schließlich eine*r Kolleg*in. Die bereits in Textform umgewandelten Dialoge haben die Forschenden von unabhängigen Fachleuten systematisch manuell annotieren lassen. Dabei fokussierten sie drei Analyseebenen: die Beziehung des Themas zum Hauptthema (z. B. Unterthema oder verwandtes Thema), die Dialoghandlung (z. B. Kontrollfrage oder informierende Aussage) und den Erklärungsschritt (z. B. Prüfen von Vorwissen oder Erklären). Für jede Dimension entwickelten die Forschenden Modelle für Vorhersagen, die sie in Experimenten prüften.

„Unsere ersten Experimente deuten darauf hin, dass eine Vorhersage der annotierten Dimensionen machbar ist“, fasst Wachsmuth zusammen. „Mit unseren Ergebnissen legen wir den Grundstein in Richtung einer menschenzentrierten erklärbaren KI. Intelligente Systeme können auf diese Weise lernen, wie sie auf die Reaktionen der Gesprächspartner*innen reagieren und ihre Erklärungen anpassen können.“

Forschungsartikel für angesehene Konferenz

Ihre gesammelten Daten und die Ergebnisse fassten die Forschenden Wachsmuth und Alshomary in ihrem Artikel „Mama Always Had a Way of Explaining Things So I Could Understand: A Dialogue Corpus for Learning to Construct Explanations” zusammen. Vorstellen werden sie ihn auf der 29th International Conference on Computational Linguistics (COLING) vom 12. bis 17. Oktober in Gyeongju, Südkorea. Die COLING findet alle zwei Jahre statt und ist eine der wichtigsten internationalen Konferenzen auf dem Gebiet der Verarbeitung natürlicher Sprache.