Projekt A02: Verstehensprozess einer Erklärung beobachten und auswerten

Wenn Menschen etwas erklärt bekommen, signalisieren sie ihr Verstehen oder Nicht-Verstehen zum einen mit verbalen Äußerungen und zum anderen mit nichtverbalen Kommunikationsmitteln, wie beispielsweise Gestik und Mimik. Wer nickt, kann der erklärenden Person verdeutlichen, dass er*sie verstanden hat. Das Nicken kann aber ebenfalls als Aufforderung gemeint sein, mit einer Erklärung fortzufahren, und ist im Kontext des Gesprächs einzuschätzen. Die Linguist*innen und Computerlinguist*innen untersuchen im Projekt A02, wie Personen – und zukünftig Maschinen – beim Erklären erkennen, dass ihre Gesprächspartner*innen sie verstehen oder nicht verstehen. Dafür betrachtet das Forschungsteam 80 Dialoge, in denen eine Person einer anderen ein Gesellschaftsspiel erklärt. Diese untersuchen die Wissenschaftler*innen auf kommunikative Feedbacksignale, die auf verschiedene Grade des Verstehensprozesses hindeuten. Die Ergebnisse aus den Analysen fließen in ein intelligentes System ein, das in der Lage sein soll, Feedbacksignale wie Kopfnicken zu erfassen und bezüglich des signalisierten Verstehens zu interpretieren.

Forschungsgebiete: Informatik, Linguistik

Hilfskräfte

Nico Dallmann - Universität Bielefeld

Sonja Friedla - Universität Paderborn

Jule Kötterheinrich - Universität Paderborn

Daniel Mohr - Universität Paderborn

Celina Nitschke, Universität Paderborn

Göksun Beeren Usta - Universität Bielefeld

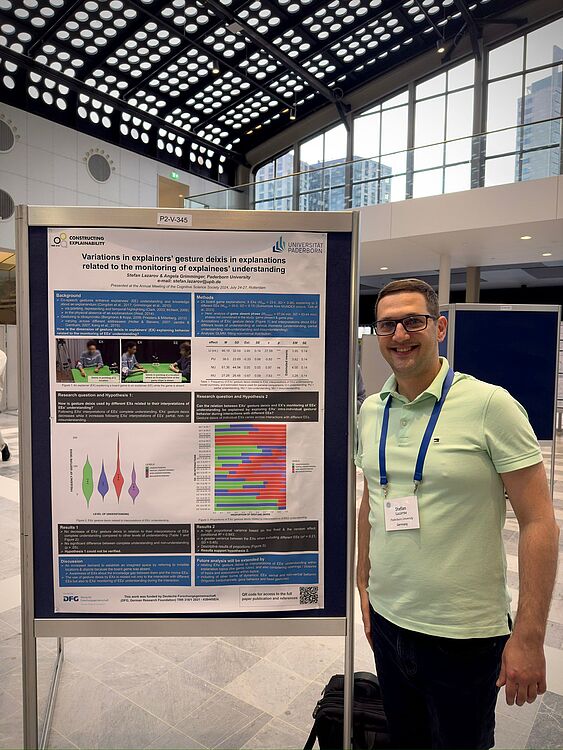

Poster

Konferenz-Poster präsentiert auf der CogSci 2024 zur Publikation "Variations in explainer's gesture deixis in explanations related to the monitoring of explainees' understanding" von Stefan Lazarov und Angela Grimminger.

Konferenz-Poster präsentiert auf dem Symposium Series on Multimodal Communication 2023 mit dem Titel "An Unsupervised Method for Head Movement Detection" von Yu Wang und Hendrik Buschmeier.

Konferenz-Poster präsentiert auf dem Symposium Series on Multimodal Communication 2023 mit dem Titel "The relation between multimodal behaviour and elaborartions in exlpanations" von Stefan Lazarov und Angela Grimminger.

Publikationen

How much does nonverbal communication conform to entropy rate constancy?: A case study on listener gaze in interaction

Y. Wang, Y. Xu, G. Skantze, H. Buschmeier, in: Findings of the Association for Computational Linguistics ACL 2024, Bangkok, Thailand, 2024, pp. 3533–3545.

Turn-taking dynamics across different phases of explanatory dialogues

P. Wagner, M. Włodarczak, H. Buschmeier, O. Türk, E. Gilmartin, in: Proceedings of the 28th Workshop on the Semantics and Pragmatics of Dialogue, Trento, Italy, 2024, pp. 6–14.

Conversational feedback in scripted versus spontaneous dialogues: A comparative analysis

I. Pilán, L. Prévot, H. Buschmeier, P. Lison, in: Proceedings of the 25th Meeting of the Special Interest Group on Discourse and Dialogue, Kyoto, Japan, 2024, pp. 440–457.

Automatic reconstruction of dialogue participants’ coordinating gaze behavior from multiple camera perspectives

A.N. Riechmann, H. Buschmeier, in: Book of Abstracts of the 2nd International Multimodal Communication Symposium, Frankfurt am Main, Germany, 2024, pp. 38–39.

A model of factors contributing to the success of dialogical explanations

M. Booshehri, H. Buschmeier, P. Cimiano, in: Proceedings of the 26th ACM International Conference on Multimodal Interaction, ACM, San José, Costa Rica, 2024, pp. 373–381.

Predictability of understanding in explanatory interactions based on multimodal cues

O. Türk, S. Lazarov, Y. Wang, H. Buschmeier, A. Grimminger, P. Wagner, in: Proceedings of the 26th ACM International Conference on Multimodal Interaction, San José, Costa Rica, 2024, pp. 449–458.

Towards a BFO-based ontology of understanding in explanatory interactions

M. Booshehri, H. Buschmeier, P. Cimiano, in: Proceedings of the 4th International Workshop on Data Meets Applied Ontologies in Explainable AI (DAO-XAI), International Association for Ontology and its Applications, Santiago de Compostela, Spain, 2024.

Variations in explainers’ gesture deixis in explanations related to the monitoring of explainees’ understanding

S.T. Lazarov, A. Grimminger, in: Proceedings of the Annual Meeting of the Cognitive Science Society, 2024.

Explain with, rather than explain to How explainees shape their own learning

J.B. Fisher, K.J. Rohlfing, E. Donnellan, A. Grimminger, Y. Gu, G. Vigliocco, Interaction Studies 25 (2024) 244–255.

Towards a Computational Architecture for Co-Constructive Explainable Systems

H. Buschmeier, P. Cimiano, S. Kopp, J. Kornowicz, O. Lammert, M. Matarese, D. Mindlin, A.S. Robrecht, A.-L. Vollmer, P. Wagner, B. Wrede, M. Booshehri, in: Proceedings of the 2024 Workshop on Explainability Engineering, ACM, 2024, pp. 20–25.

Does listener gaze in face-to-face interaction follow the Entropy Rate Constancy principle: An empirical study

Y. Wang, H. Buschmeier, in: Findings of the Association for Computational Linguistics: EMNLP 2023, Singapore, 2023, pp. 15372–15379.

Modeling Feedback in Interaction With Conversational Agents—A Review

A. Axelsson, H. Buschmeier, G. Skantze, Frontiers in Computer Science 4 (2022).

Alle Publikationen anzeigen