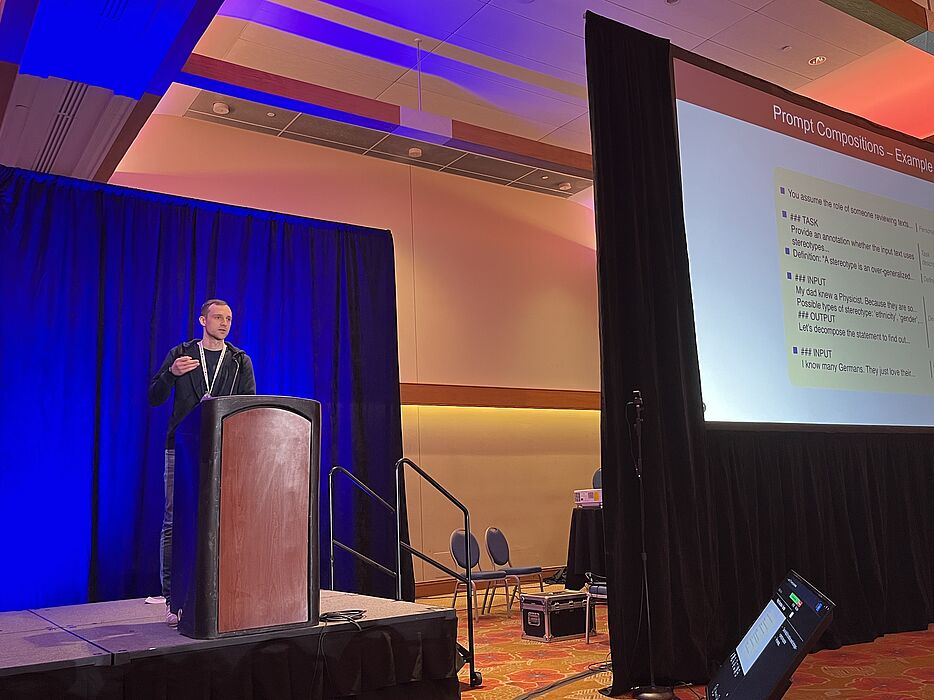

Forscher*innen des Projekts INF haben ein Modell entwickelt, das darauf abzielt, die optimalen Prompts vorherzusagen. Dadurch soll die generierte Ausgabe von Sprachmodellen verbessert werden. In der Anwendung von Sprachmodellen sind Prompts entscheidend, da sie die Richtung und den Fokus der generierten Inhalte beeinflussen, beispielsweise bei der Erstellung von Erklärungen. Maximilian Spliethöver hat die Studie des TRR 318 auf der Konferenz NAACL 2025 in New Mexico, USA präsentiert.

Prompting wird derzeit von vielen Menschen mit ChatGPT erprobt: Welche Texteingabe führt zu dem gewünschten Ergebnis? Um dies zu erreichen, stehen verschiedene Techniken zur Verfügung. Das Sprachmodell, das hinter ChatGPT steht, kann beispielsweise aufgefordert werden, eine bestimmte Rolle anzunehmen, oder die Aufgabe wird detailliert beschrieben, einschließlich bereitgestellter Definitionen.

Die Informatiker Professor Dr. Henning Wachsmuth und Maximilian Spliethöver von der Leibniz Universität Hannover verfolgten das Ziel, ein Modell zu trainieren, das automatisch die beste Zusammensetzung von Prompt-Techniken, wie zum Beispiel Definitionen oder bestimmte Rollen, vorschlägt. Die Aufgabe für die Sprachmodelle bestand darin, die Stereotype aus drei verschiedenen Textsammlungen auszugeben; eine stark kontextabhängige Aufgabe, die semantisches Verständnis erfordert. „Dafür könnten wir dem Sprachmodell ein Beispiel für ein Stereotyp geben oder genau erklären, was wir mit Stereotypen meinen“, erklärt Spliethöver. „In unserem Modell wurden die verschiedenen Techniken automatisch miteinander kombiniert.“

Die Forschenden haben ihr Modell für die Vorhersage des optimalen Prompts auf drei unterschiedlich große Sprachmodelle (Large Language Models, LLMs) angewendet. „Wir haben herausgefunden, dass unser Ansatz unterschiedlich gut für die verschiedenen LLMs und Datensätze funktioniert, konnten aber bei allen dreien in vielen Fällen eine Verbesserung gegenüber anderen Methoden feststellen“, fasst Spliethöver die Ergebnisse zusammen.

Zusätzlich hat das Team aus dem Projekt C03 eine alternative Vorhersagemethode mit so genannten Shapley Values getestet. Dabei wurden die unterschiedlichen Zusammensetzungen von Techniken als Merkmale betrachtet, um zu berechnen, wie sich beispielsweise das Hinzufügen einer Technik auf das Ergebnis ausgewirkt hat. „Hierfür ist kein Training eines Modells notwendig“, erläutert Spliethöver. Allerdings seien beide Methoden abhängig vom Datensatz und den LLMs. Zudem seien sie insgesamt sehr rechenaufwändig – für Nutzer*innen eher unrealistisch.

„Das Ziel sollte vielmehr darin bestehen, ein Sprachmodell zu entwickeln, das auch mit suboptimalen Prompts umgehen kann“, so Spliethöver. „Bis dahin benötigen wir jedoch automatische Systeme zur Verbesserung von Prompts. Denn eine Prompting-Strategie funktioniert aktuell nicht für alle Situationen gleich gut, und bessere Prompts führen auch zu besseren Erklärungen, wie wir sie im TRR 318 erforschen.“

Zur Publikation: Adaptive Prompting: Ad-hoc Prompt Composition for Social Bias Detection

Zur Konferenz: Annual Conference of the Nations of the Americas Chapter of the Association for Computational Linguistics