Forschungsprofil des TRR 318

Algorithmische Ansätze wie das maschinelle Lernen werden immer komplexer. Die Undurchsichtigkeit erschwert es, die von Künstlicher Intelligenz (KI) vorgeschlagenen Entscheidungen nachzuvollziehen und zu akzeptieren. Als Antwort auf diese gesellschaftliche Herausforderung haben Informatiker*innen begonnen, selbsterklärende Algorithmen zu entwickeln, die Erklärungen auf intelligente Weise bereitstellen (XAI). Die XAI-Programme interagieren allerdings nur eingeschränkt mit Menschen und berücksichtigen weder das Informationsbedürfnis der Adressat*innen noch den gegebenen Kontext. Darin besteht das Risiko, Erklärungen zu erzeugen, die von den Empfänger*innen nicht verstanden werden.

Die Mitglieder des Sonderforschungsbereichs/Transregios (TRR) 318 stellen diese Sichtweise infrage und schlagen eine Ko-Konstruktion der Erklärung vor: Darin nehmen die Erklärungsempfänger*innen aktiv an Erklärprozessen teil, indem sie das Ziel und den Prozess mitgestalten. Die Mechanismen von Erklärbarkeit und Erklärungen untersuchen die 21 Projektleiter*innen und rund 50 wissenschaftliche Mitarbeiter*innen in interdisziplinärer Zusammenarbeit: Sie forschen in den Bereichen Informatik, Linguistik, Medienwissenschaft, Philosophie, Psychologie, Soziologie und Wirtschaftswissenschaft.

Die Ergebnisse des TRR 318 leisten einen Beitrag zur Entwicklung von

- einem multidisziplinären Verständnis vom Erklärprozess, der an den Prozess des Verstehens und den ihn beeinflussenden Kontextfaktoren gekoppelt ist,

- Computermodellen und komplexen KI-Systemen, die ihre Erklärung effizient für die Adressat*innen in einem aktuellen Kontext generieren und

- einer Theorie der Erklärungen als soziale Praktiken, die die Erwartungen der Kommunikationspartner*innen und ihre Rollen in der Interaktion berücksichtigt.

Diese Grundlage für erklärbare und verstehbare KI-Systeme ermöglicht es den Bürger*innen, sich aktiv und kritisch an einer digitalen Gesellschaft zu beteiligen.

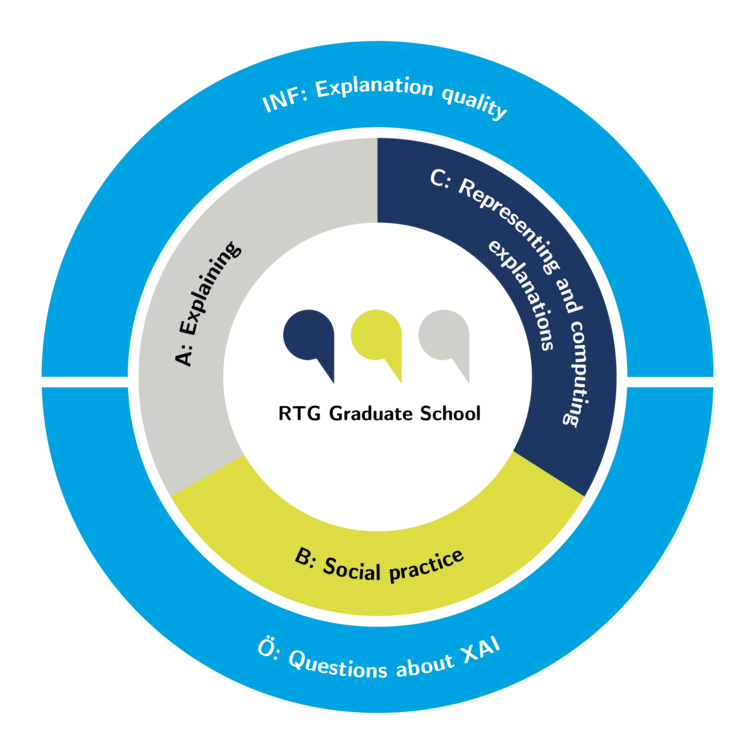

Die Forschungsbereiche des TRR 318 gliedern sich in A „Explaining“ / „Erklärprozess“, B „Social practice“ / „Soziale Praktik“ und C „Representing and computing explanations“ / „Darstellung und Berechnung von Erklärungen“. Die drei Bereiche wiederum teilen sich in interdisziplinäre Teilprojekte auf.

Übergreifend schafft das INF-Projekt eine Forschungsstruktur, das Ö-Projekt sorgt für einen Austausch mit der Öffentlichkeit, das Z-Projekt verwaltet die Organisation und Finanzen und das RTG-Projekt sorgt für die Ausbildung der Doktorand*innen und Postdoktorand*innen.